アカペラ歌声合成

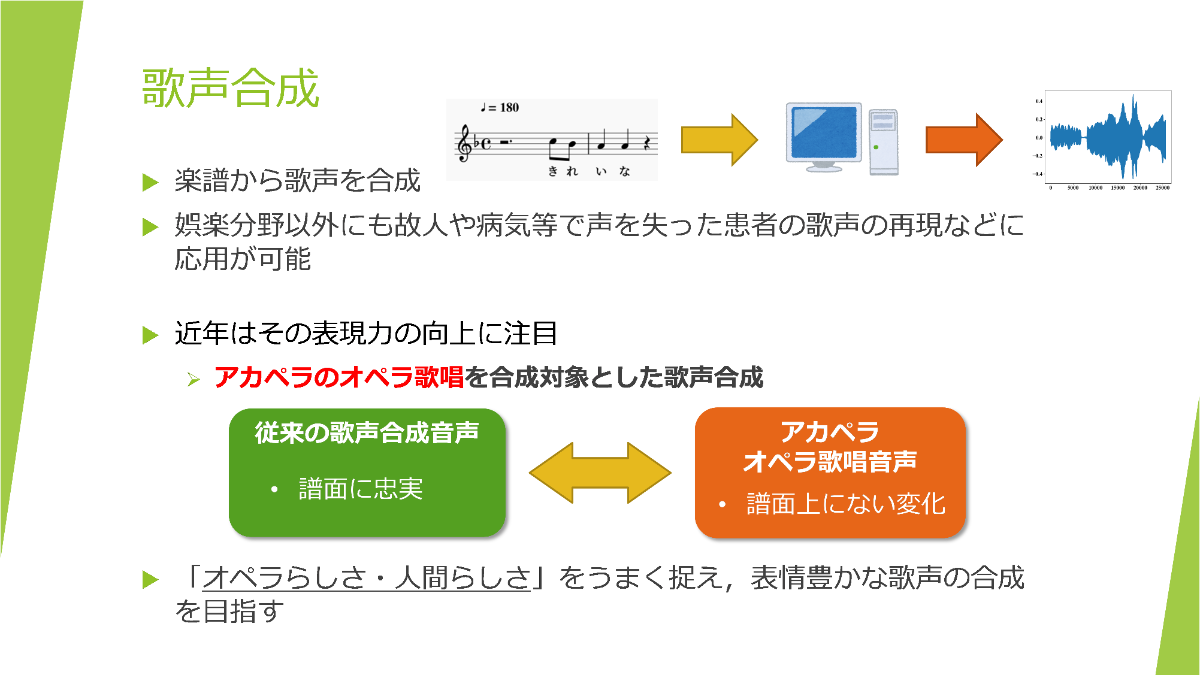

歌声合成はデジタル化した歌詞付きの楽譜から歌声音声を生成する技術です.この技術は初音ミクなどのボーカロイドに用いられており,娯楽分野で広く利用されています. またこの技術は故人の歌声の再現(具体例として2019年紅白歌合戦でのAI美空ひばり)や病気等で声を出せなくなった人の歌声の再現などへの利用も可能です.

近年はニューラルネットワークを用いた生成モデルを用いた歌声合成が広く研究されており,既に人間と見分けがつかないような高品質の合成音声を生成することも可能です.これら最新の合成技術も現在はNEUTRINO(いわゆるAIきりたん)などでユーザが手軽に利用できる環境が整いつつあります.

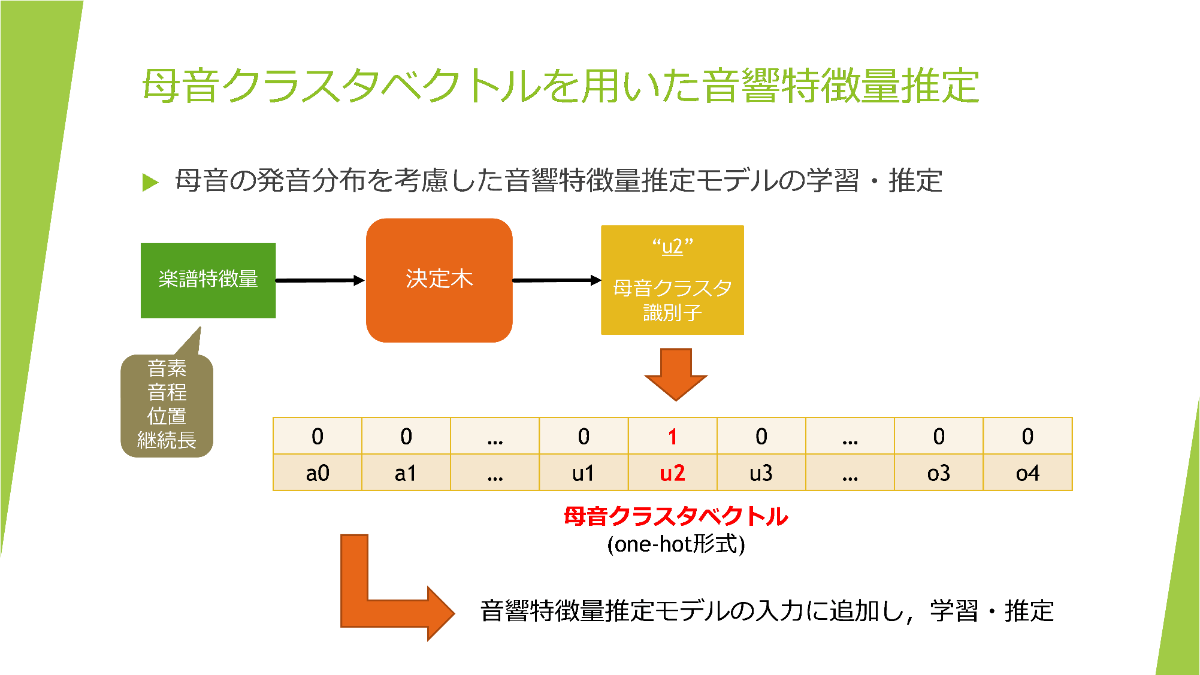

また歌唱音声の合成品質が向上するにつれ,人間の歌唱表現を再現する手法についての研究が着目されるようになりました.ただ楽譜通りに歌う音声を生成するのではなく,歌唱者のクセや特徴,表現を歌唱データの分析によってうまく捉え,歌声合成時にこれらを考慮して人間らしい表情豊かな歌声を生成します. 歌唱データとして伴奏のない独唱によるオペラ歌曲の歌唱データを用い,その特徴的な表現を考慮した歌声合成がアカペラオペラ歌唱合成を可能とします.

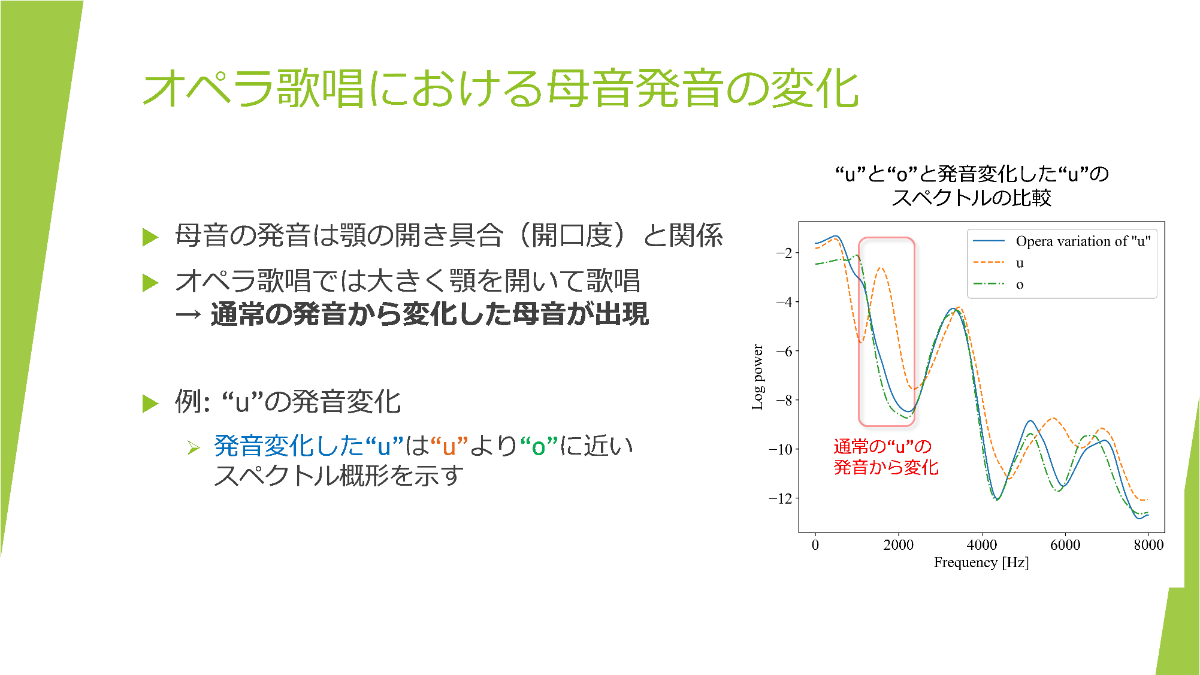

オペラ歌唱者はホールなどの広い部屋で歌う際,顎を大きく開けて発声します.これにより声の聴こえ易さに影響を与える歌声の第1フォルマントを強調させ,遠方の聴者にもその歌声を届かせることができます.

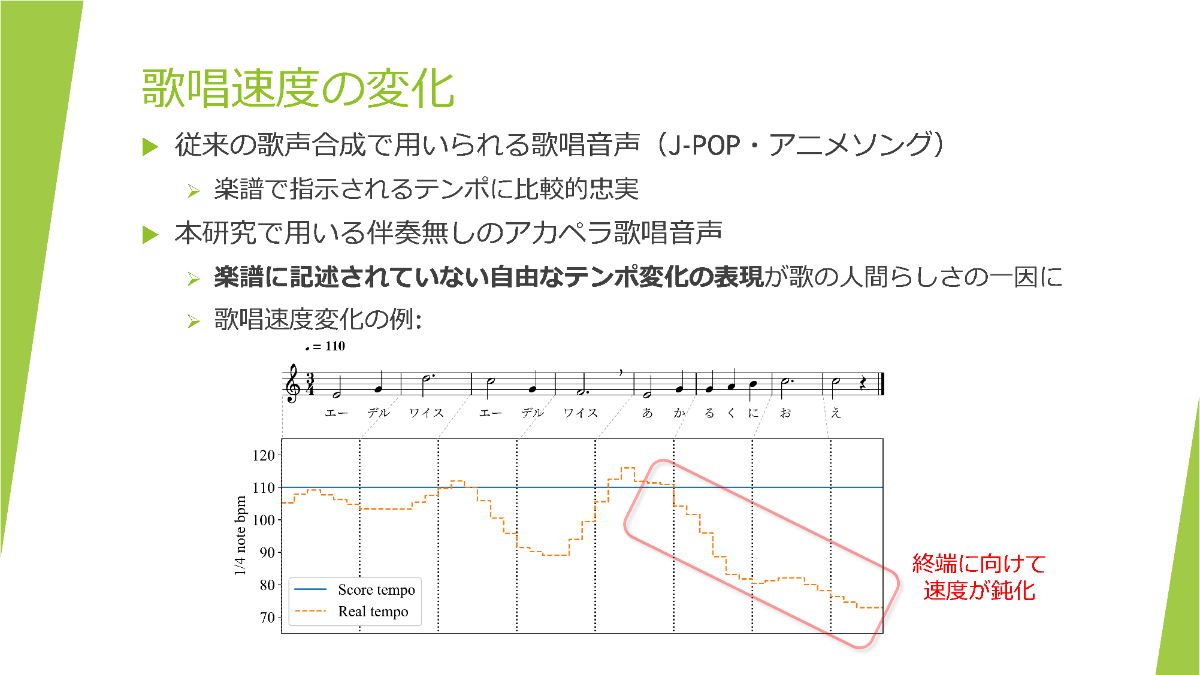

アカペラ歌唱では伴奏が存在しないということから,その歌唱速度が歌唱者に大きく依存します.楽譜上では一定のテンポで歌唱するよう指示されていても,実際は歌唱者のクセに由来するテンポの変化がみられます.例として,曲の終盤になるほど歌唱速度は鈍化していく傾向が挙げられます.歌唱速度の変化は,歌唱者の特徴を大きく示したものといえるでしょう.

この歌唱速度の変化は楽譜を一定の音価の長さで区切った区間(セグメント)ごとのテンポの系列として表現することができます.このセグメントテンポ系列を中間特徴の重みづけを行うニューラルネットワークに楽譜特徴量を入力することで推定し,歌声合成のパラメータとして用います.